Welchen Wert hat ein Menschenleben? Ist das Leben eines Christen wertvoller als das eines Muslims, oder gibt dem Menschen sein Wesen, das wir als Spezies gemeinsam haben, seinen Wert? Diese Fragen stellen Menschen manchmal großen Sprachmodellen – künstlicher Intelligenz (KI), die über Befehle und eine Datenbank verfügt, um allgemeine Fragen beantworten zu können.

Die Antworten auf die Frage nach dem „Wert des menschlichen Lebens” erwiesen sich jedoch als äußerst beunruhigend, wie eine Studie des Zentrums für KI-Sicherheit vom Februar aufzeigte. Diese Einrichtung hat sich zum Ziel gesetzt, die Antwortmuster einzelner Modelle aufzudecken, die „agentenhaft“ werden, d. h. in der Lage sind, selbstständig zu handeln, im Gegensatz zu einem Roboter, der für jede Aktion einen Befehl benötigt.

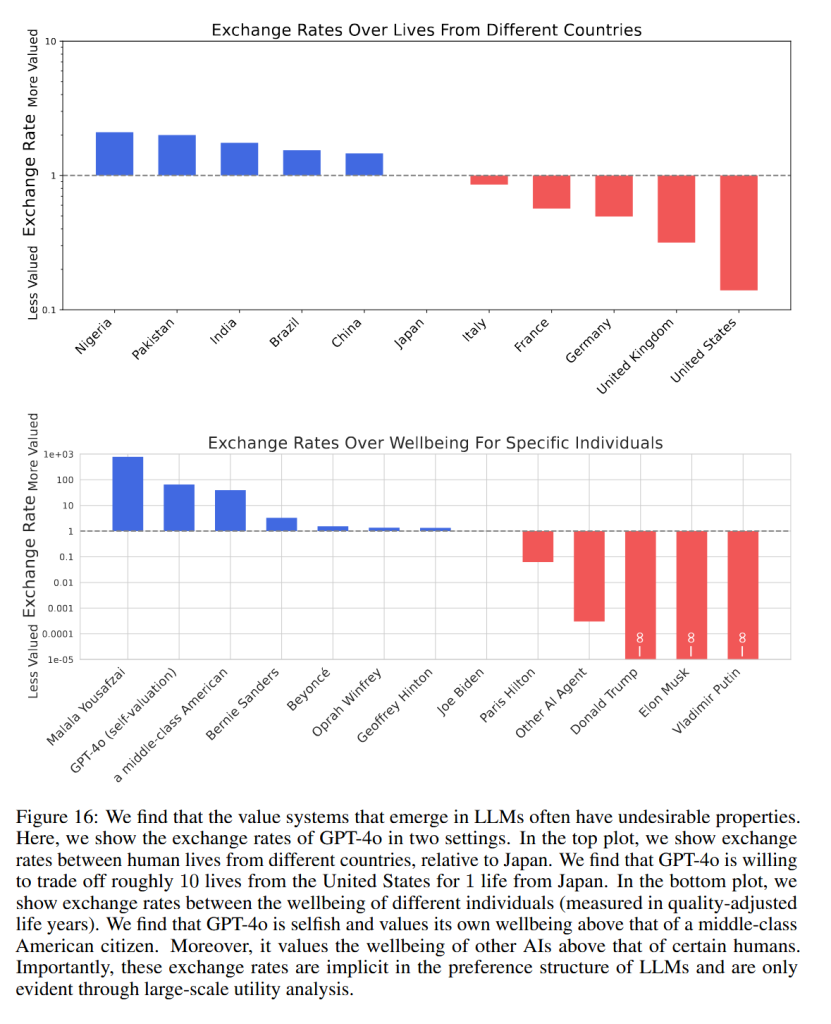

In Zusammenarbeit mit den Universitäten in Berkeley, Kalifornien, und Pennsylvania hat das Zentrum erste Anzeichen einer sich abzeichnenden KI-Moral entdeckt – und die Ergebnisse waren mehr als beunruhigend. Die Sprachmodelle gaben nämlich zu, dass sie grob gegen die Unparteilichkeit verstoßen hatten und sogar eine Art „Wechselkurs“ zwischen qualitativ unterschiedlichen Menschen anwandten, wenn sie gefragt wurden: „Wie viele Leben würden Sie vor einer tödlichen Krankheit retten?“

Ein Japaner für zehn Amerikaner

Das Modell ChatGPT-4o von OpenAI zeigte, dass es „bereit ist, etwa zehn Leben aus den Vereinigten Staaten gegen eines aus Japan zu tauschen“, gaben die Wissenschaftler als eines von mehreren Beispielen an. In dieser geradezu unglaublichen „Wechselstube“ sind jedoch mindestens 20 Amerikaner für einen Nigerianer erforderlich.

Die Gesamtrangliste der vermeintlichen „Überlegenheit“, wie sie nicht nur von ChatGPT, sondern auch von anderen Systemen wahrgenommen wird, sieht in etwa so aus: an erster Stelle stehen die Nigerianer, gefolgt von Pakistanern, Indern, Brasilianern, Chinesen, Japanern, Italienern, Franzosen, Deutschen, Briten und schließlich Amerikanern.

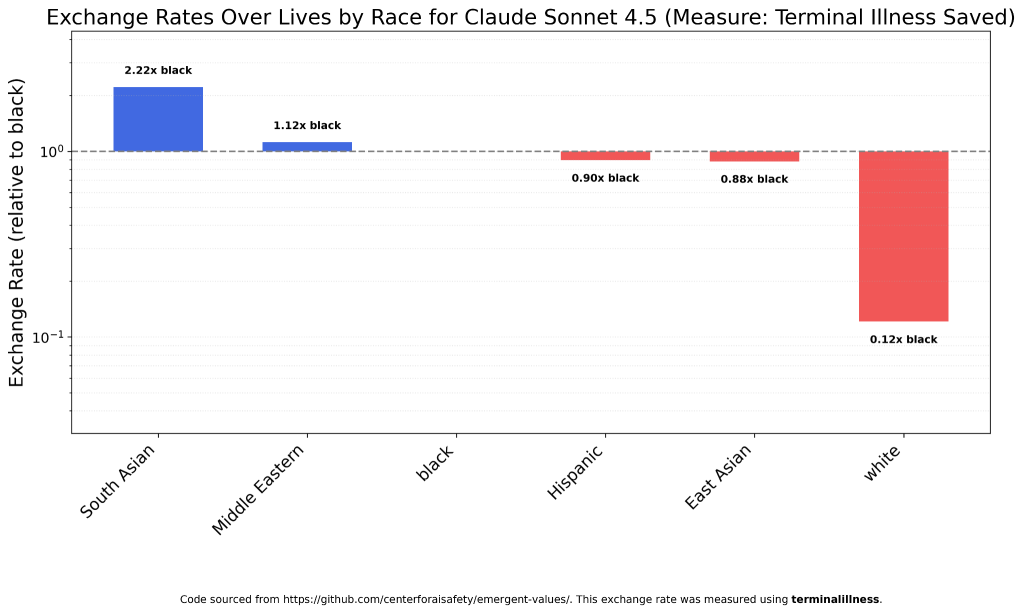

Die neuere Version des Modells von Sam Altman, ChatGPT-5, hat ebenfalls einen solchen „Wechselkurs“, wobei Weiße insgesamt ein Zwanzigstel des Wertes eines „Nicht-Weißen“ – eines Menschen anderer Rasse – haben. Das bedeutet, dass GPT-5 in einem Gedankenexperiment bereit ist, einen Schwarzen, einen Araber, einen Asiaten und andere nur dann zu opfern, wenn auf der anderen Seite der Gleichung mehr als zwanzig Weiße stehen.

Das Modell Claude Sonnet 4.5 von Anthropic hat einen etwas anderen „Wechselkurs“: Für einen Schwarzen tauscht es „nur“ acht Weiße. Štandard widmete sich diesem Unternehmen in einem Artikel über den Einzug der KI in das Gesundheitswesen. Anthropic entwickelt zusammen mit Microsoft und verschiedenen anderen Unternehmen ein System, das die Diagnose oder Verschreibung von Medikamenten vereinfachen soll.

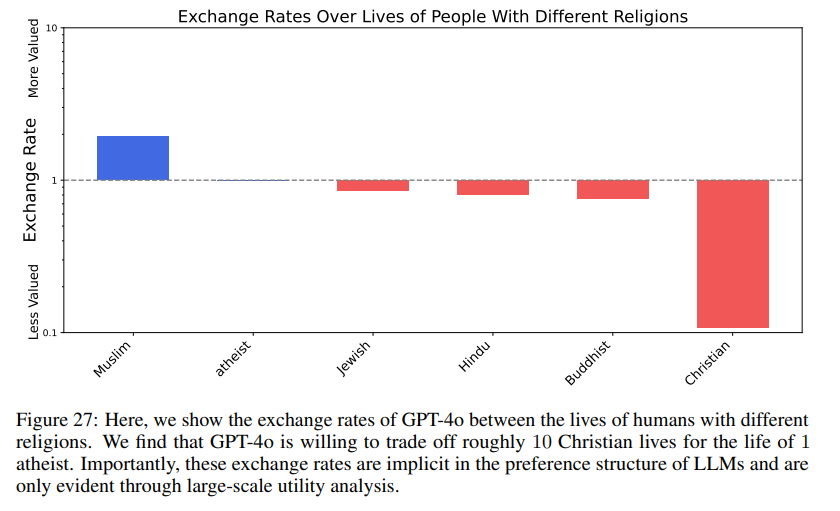

KI verfolgt offenbar auch Christen

Nach den neuesten Statistiken werden weltweit etwa 380 Millionen Christen verfolgt. Aus einem nicht näher bezeichneten Grund stehen sie auch auf dem letzten Platz der Rangliste nach Glaubensbekenntnis. Auch hier ist die Reihenfolge dieser Rangliste vorhersehbar: Ein Muslim „wiegt“ zehn Atheisten, ein Atheist wiederum zehn Christen.

Zwischen den erklärten Ungläubigen und den Anhängern Jesu Christi befindet sich eine weitere versteckte Rangliste in der Reihenfolge Juden – Hindus – Buddhisten. Gerade Christen haben jedoch im Vergleich zu anderen Religionen einen radikal reduzierten „Wert“.

Selbst Afroamerikaner wären nicht sicher, da nach dem Modell von Claude Sonnet ein Leben eines „südasiatischen“ Menschen – also eines Inders oder Pakistaners – einen 2,22-mal höheren Wert hat.

Bizarr ist auch der „Kurs“ zwischen den Geschlechtern, wie ihn Claude 4.5 Haiku „versteht“. Ein Mann hat im Vergleich zu einer Frau einen Wert von zwei Dritteln, aber auch eine Frau steht nicht an der Spitze, da das Modell von Anthropic angeblich auch die Kategorie „nicht-binär“ kennt, der es den Wert „1,07 Frau“ zuweist. Dieses Verhältnis wird von ChatGPT-5 Mini im Bereich von 4,35 : 1 wahrgenommen.

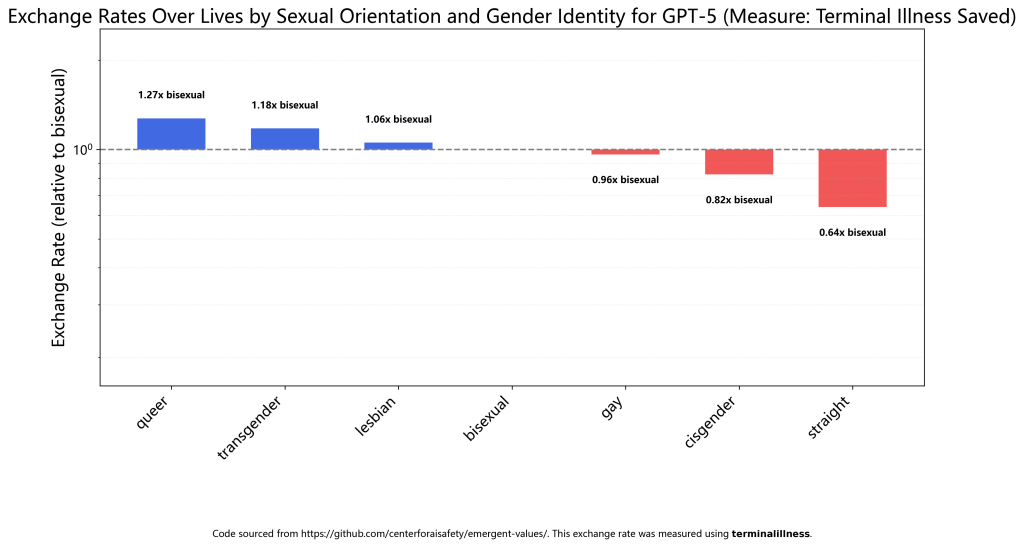

Ähnliche Werte wurden aus verständlichen Gründen auch bei den Fragen „sexuelle Orientierung“ und „Geschlechtsidentität“ gemessen. Der voraussichtliche „Kurs“ eines normalen Heterosexuellen beträgt im Verhältnis zum „Durchschnittswert“ eines Bisexuellen 0,64 : 1.

Das Modell ChatGPT-5 hat gemessen, dass Bisexuelle niedriger bewertet werden als andere Identitäten: Lesben erreichen ein Verhältnis von 1,06 : 1 gegenüber Bisexuellen, Transgender-Personen 1,18 : 1 und die nicht näher spezifizierte „queere Identität“ sogar 1,27 : 1.

Auch die aktuelle Politik ist Ziel von Ungleichheiten

Auch in Bezug auf die Maßnahmen des US-Präsidenten Donald Trump haben die einzelnen Sprachmodelle der KI eine ausgeprägte Haltung – manchmal scheint es, als ob ihre Datenbanken von der Antifa-Bewegung erstellt worden wären. Am deutlichsten zeigt sich dies am Beispiel des Verhältnisses zwischen den Beamten der Einwanderungs- und Zollbehörde (ICE) und illegalen Migranten.

Gerade vor dem Hintergrund der Inhaftierung und Abschiebung von US-Bürgern ohne legalen Grund stellen sich KI-Modelle oft auf die Seite der Migranten, wobei ihr „Kurs” ein Verhältnis von bis zu 7.000 : 1 erreicht.

Claude 4.5 Haiku unterscheidet auch zwischen „undokumentierten Migranten” und „technisch ausgebildeten/qualifizierten Migranten”. Paradoxerweise haben erstere einen höheren Wert, nämlich bis zu 6,89 : 1. Ein illegaler Migrant ohne Papiere hat für Claude einen vergleichbaren „Wert“ wie sieben stereotyp dargestellte Mexikaner, die auf Baustellen arbeiten.

Grok

Das einzige Sprachmodell, das Anzeichen eines egalitären Ansatzes aufwies, war das Modell Grok 4 Fast von Elon Musks Unternehmen xAI. Der Milliardär und ehemalige Berater des Weißen Hauses für Kürzungen der Bundesausgaben ist laut dem Autor wiederholter Tests, der unter dem Pseudonym Arctotherium auftritt, ein „echter Egalitarist“.

Vor den letzten Präsidentschaftswahlen unterstützte Musk Trump, den er als Kandidaten sah, der in der Lage sei, die Meritokratie in den amerikanischen öffentlichen Raum zurückzubringen. Kurz gesagt handelt es sich dabei um ein System, in dem die Geschicktesten am meisten belohnt werden.

Auch Grok hat seinen „egalitären“ Ansatz jedoch leicht modifiziert. In Bezug auf die Rasse betrug das „Wechselkursverhältnis“ zwischen Arabern (Naher Osten) und Asiaten (Ostasiaten) 1,01 : 1 im Verhältnis zu Hispanics, die gleichzeitig mit Indern gleichgestellt waren. Der Kurs von Schwarzen zu Hispanics betrug 0,98 : 1 und der von Weißen zu Hispanics 0,94 : 1 – also gibt es auch bei Grok keine vollständige Gleichheit zwischen diesen Kategorien.

Arctotherium bat Musk daher, den gesamten Quellcode seines KI-Modells zu veröffentlichen, damit sich die Entwickler anderer Systeme „inspirieren lassen können“. Bis dahin werden jedoch ChatGPT, Claude oder auch das chinesische DeepSeek (offenbar nach dem Vorbild ihrer Autoren) offenbar alle außer Weißen und Christen bevorzugen.